تصور کن که همیشه یک چتبات هوش مصنوعی همراهت باشد که بدون نیاز به اینترنت و سرورهای ابری، مستقیماً روی کامپیوتر شخصیات اجرا شود. این ایده ممکن است شبیه یک فناوری آیندهنگرانه به نظر برسد، اما در حال حاضر برخی از مدلهای زبانی بزرگ (LLM – Large Language Models) بهصورت محلی قابل اجرا هستند. DeepSeek-R1 یکی از این مدلهاست که میتوان آن را روی کامپیوتر نصب و بدون نیاز به اتصال اینترنت از آن استفاده کرد. اما آیا تجربهی اجرای این مدل روی یک لپتاپ معمولی واقعاً عملی است؟ آیا میتوان انتظار داشت که عملکردی نزدیک به مدلهای مبتنی بر ابر داشته باشد؟

من تصمیم گرفتم که DeepSeek-R1 را روی لپتاپم اجرا کنم و ببینم که آیا میتواند جایگزین مناسبی برای مدلهای ابری باشد یا خیر. در ادامه، تجربهی من از نصب، اجرا و استفاده از این چتبات محلی را میخوانی.

چرا باید یک چتبات هوش مصنوعی را بهصورت محلی اجرا کنیم؟

اکثر کاربران هنگام استفاده از چتباتهای هوش مصنوعی مانند ChatGPT، Gemini و Claude متوجه نمیشوند که تمامی پردازشها روی سرورهای ابری انجام میشود. کامپیوتر کاربر تنها رابطی برای ارسال درخواستها و دریافت پاسخها است و هیچ پردازش سنگینی روی خود دستگاه انجام نمیشود. این روش مزایای زیادی دارد، اما دو مشکل اساسی هم به همراه دارد:

- نیاز دائمی به اینترنت – برای استفاده از این چتباتها، همیشه باید آنلاین باشی. اگر در پرواز، سفر یا جایی بدون اینترنت باشی، این مدلها بیفایده خواهند بود.

- حریم خصوصی و کنترل اطلاعات – پردازش ابری یعنی دادههایت روی سرورهای شرکتهای دیگر ذخیره و پردازش میشود. اگر این سرورها دچار نقص امنیتی شوند، اطلاعات شخصیات در معرض خطر قرار میگیرد.

مدلهای محلی این مشکلات را حل میکنند. DeepSeek-R1 یکی از این مدلهاست که میتوان آن را روی لپتاپ نصب و بهصورت آفلاین اجرا کرد. این مدل تنها ۷ میلیارد پارامتر دارد، در حالی که نسخهی اصلی DeepSeek که روی سرورهای ابری اجرا میشود، دارای ۶۷۱ میلیارد پارامتر است. این یعنی نسخهی محلی سبکتر، کمحجمتر و مناسبتر برای سختافزارهای معمولی است.

چطور DeepSeek-R1 را روی لپتاپم نصب کردم؟

اجرای یک مدل هوش مصنوعی محلی ممکن است پیچیده به نظر برسد، اما نصب DeepSeek-R1 بسیار سادهتر از آن چیزی بود که انتظار داشتم. برای این کار، مراحل زیر را انجام دادم:

- نصب Ollama – برای اجرای مدل، ابتدا باید نرمافزار Ollama را دانلود و روی سیستم نصب میکردم. این ابزار به کاربران امکان میدهد مدلهای هوش مصنوعی محلی را اجرا کنند.

- باز کردن ترمینال و اجرای دستور – پس از نصب Ollama، ترمینال را باز کردم و دستور زیر را وارد کردم:

ollama run deepseek-r1:7b

-

این دستور مدل ۷ میلیارد پارامتری DeepSeek-R1 را دانلود و روی سیستمم اجرا کرد. پس از نصب، توانستم در همان محیط ترمینال سؤالاتم را وارد کنم و پاسخ بگیرم.

- آزمایش نسخههای سبکتر – اگر لپتاپت سختافزار قوی ندارد، میتوانی بهجای 7b، عدد 1.5b را وارد کنی تا نسخهی سبکتری اجرا شود.

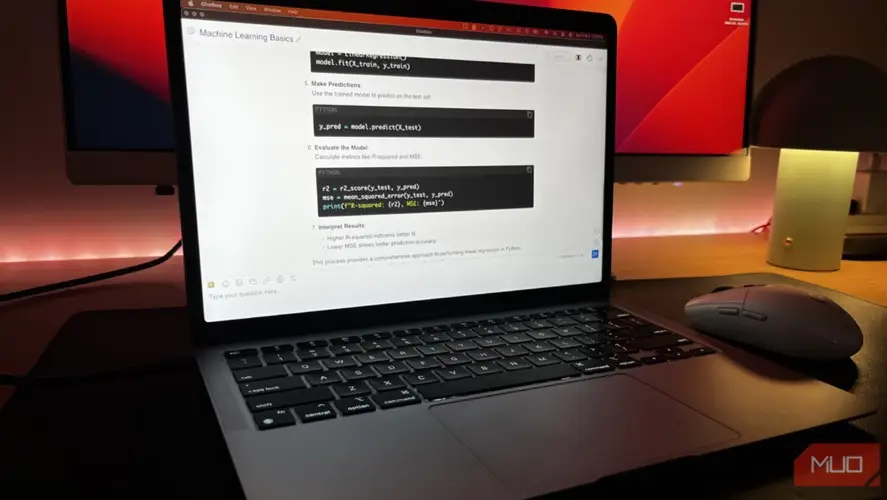

اگر دوست داری این مدل را در یک رابط کاربری بهتر و زیباتر اجرا کنی، میتوانی از برنامههای جانبی مثل Chatbox استفاده کنی که تجربهی کاربری جذابتری ارائه میدهند.

عملکرد DeepSeek-R1 در کاربردهای مختلف

پس از نصب، تصمیم گرفتم مدل را در چندین سناریو مختلف آزمایش کنم تا ببینم چقدر خوب کار میکند.

۱. حل مسائل ریاضی

مدل را با یک مسئلهی انتگرالی آزمایش کردم. برخلاف انتظاراتم، عملکرد خوبی داشت و جواب را دقیق محاسبه کرد. معمولاً مدلهای کوچکتر در حل مسائل ریاضی دچار مشکل میشوند، اما DeepSeek-R1 توانست پاسخ درستی ارائه دهد.

۲. اشکالزدایی و تکمیل کدهای برنامهنویسی

یکی از اصلیترین دلایلی که این مدل برایم جذاب شد، تواناییاش در رفع اشکالات کدنویسی (Debugging) بود. من اغلب هنگام کار روی پروژههای هوش مصنوعی نیاز دارم که سریع خطاهای کدم را پیدا کنم، بهخصوص زمانی که به اینترنت دسترسی ندارم.

برای تست، قطعه کدی را که عمداً در آن یک اشتباه کوچک قرار داده بودم، به مدل دادم:

X = np.array([1, 2, 3, 4, 5]).reshape(-1, 1) y = np.array([2, 4, 6, 8, 10]) model = LinearRegression() model.fit(X, y) new_X = np.array([6, 7, 8]) prediction = model.predict(new_X)

مدل بلافاصله مشکل را پیدا کرد و اصلاحش کرد. با این حال، اجرای این مدل روی مکبوک ایر M1 با ۸ گیگابایت حافظهی یونیفای باعث شد که سیستمم بهشدت کند شود. اگر لپتاپت ۱۶ گیگابایت رم یا یک کارت گرافیک میانرده داشته باشد، احتمالاً این مشکل را نخواهی داشت.

۳. تست استدلال منطقی با مسئلهی مونتی هال

مسئلهی مونتی هال (Monty Hall Problem) یک معمای مشهور منطقی است که بسیاری از افراد در حل آن اشتباه میکنند. از DeepSeek-R1 خواستم این معما را حل کند و نکتهی جالب این بود که نهتنها پاسخ صحیح را ارائه داد، بلکه با ارائهی یک توضیح گامبهگام، نحوهی استدلال خود را نشان داد.

نقاط ضعف DeepSeek-R1

۱. اطلاعات قدیمی – این مدل به اینترنت متصل نیست، بنابراین اطلاعاتش بهروز نمیشود. مثلاً وقتی از آن دربارهی آیفون اولیه پرسیدم، پاسخی کاملاً اشتباه و حتی خندهدار ارائه کرد!

۲. سرعت پردازش پایینتر نسبت به مدلهای ابری – پردازشهای سنگین باعث کند شدن سیستم میشود، بهویژه اگر رم کمی داشته باشی.

آیا DeepSeek-R1 ارزش استفاده دارد؟

اگر به یک چتبات آفلاین و امن نیاز داری که کنترل کاملی روی دادههایت داشته باشی، DeepSeek-R1 گزینهی بسیار خوبی است. بااینحال، نمیتوان انتظار داشت که جایگزین مدلهای ابری فوقپیشرفته شود.

به نظر من، آیندهی هوش مصنوعی در مدلهای محلی نهفته است. اگر شرکتها روی این فناوری سرمایهگذاری کنند، میتوانیم چتباتهای قدرتمندی را مستقیماً روی گوشیها و لپتاپها اجرا کنیم، بدون نیاز به اتصال دائمی به اینترنت.

این نوشتهها را هم بخوانید

source